ЕС ввел в действие Регламент об искусственном интеллекте, что является весьма похвальным первым шагом на пути регулирования ИИ.

Он был обнародован 1 августа 2024 года и вступит в силу в полном объеме через два года.

Специальный веб-сайт “Закон ЕС об искусственном интеллекте” предоставляет обновленную информацию о последних разработках и предлагает информацию по ряду связанных с этим вопросов:

https://artificialintelligenceact.eu/

Официальный веб-сайт Европейской комиссии “Формирование цифрового будущего Европы” предоставляет полезную информацию о Регламенте об искусственном интеллекте и, таким образом, отвечает на некоторые важные вопросы:

Мы приводим здесь краткую версию:

Закон об искусственном интеллекте

Закон об ИИ – это первая в истории правовая база в области ИИ, которая устраняет риски, связанные с ИИ, и позволяет Европе играть ведущую роль в мире.

Закон об искусственном интеллекте (Регламент (ЕС) 2024/1689, устанавливающий гармонизированные правила в области искусственного интеллекта) предоставляет разработчикам и внедрителям ИИ четкие требования и обязательства в отношении конкретных видов использования ИИ. В то же время регламент направлен на снижение административной и финансовой нагрузки на бизнес, в частности на малые и средние предприятия (МСБ).

Зачем нам нужны правила, касающиеся искусственного интеллекта?

Закон об ИИ гарантирует, что европейцы могут доверять тому, что может предложить ИИ. В то время как большинство систем ИИ практически не представляют риска и могут способствовать решению многих социальных проблем, некоторые системы ИИ создают риски, которые мы должны учитывать, чтобы избежать нежелательных последствий.

Например, часто невозможно выяснить, почему система искусственного интеллекта приняла то или иное решение или спрогнозировала и предприняла то или иное действие. Таким образом, может возникнуть проблема с оценкой того, был ли кто-то несправедливо поставлен в невыгодное положение, например, при принятии решения о приеме на работу или при подаче заявки на получение государственных пособий.

Хотя существующее законодательство обеспечивает определенную защиту, его недостаточно для решения конкретных проблем, которые могут возникнуть в системах искусственного интеллекта.

Новые правила:

- направлены на устранение рисков, связанных с приложениями искусственного интеллекта

- запрещают использование ИИ, которые представляют неприемлемые риски

- определяют список приложений с высоким уровнем риска

- устанавливают четкие требования к системам ИИ для приложений с высокой степенью риска

- определяют конкретные обязательства разработчиков и поставщиков приложений ИИ с высокой степенью риска

- требуют проведения оценки соответствия до того, как данная система ИИ будет введена в эксплуатацию или представлена на рынке

- вводят в действие правоприменительную практику после вывода данной системы искусственного интеллекта на рынок

- создают структуру управления на европейском и национальном уровнях

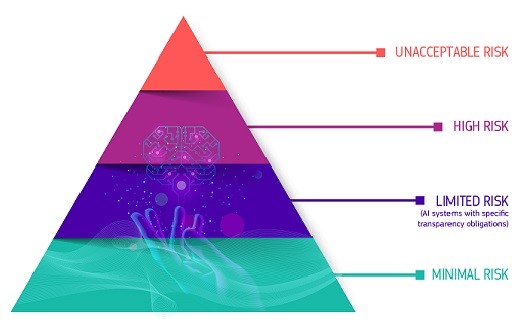

Подход, основанный на оценке рисков

Нормативная база определяет 4 уровня риска для систем искусственного интеллекта:

пирамида, показывающая четыре уровня риска: неприемлемый риск; Высокий риск; ограниченный риск; минимальный риск или его отсутствие

Все системы искусственного интеллекта, которые считаются явной угрозой безопасности, средствам к существованию и правам людей, запрещены, начиная от социальных оценок со стороны правительств и заканчивая игрушками с голосовой поддержкой, поощряющими опасное поведение.

Высокий риск

Системы ИИ, отнесенные к категории повышенного риска, включают технологии ИИ, используемые в:

- критически важных инфраструктурах (например, на транспорте), которые могут подвергать риску жизнь и здоровье граждан

- образовательная или профессиональная подготовка, которая может определить доступ к образованию и профессиональный путь в жизни человека (например, результаты экзаменов)

- компоненты безопасности продукции (например, применение искусственного интеллекта в роботизированной хирургии)

- трудоустройство, управление работниками и доступ к самозанятости (например, программное обеспечение для сортировки резюме для процедур найма)

- основные частные и государственные услуги (например, кредитный рейтинг, лишающий граждан возможности получить кредит)

- правоохранительные органы, которые могут нарушать основные права людей (например, оценка надежности доказательств)

- управление миграцией, предоставлением убежища и пограничным контролем (например, автоматизированное рассмотрение заявлений на получение визы)

- отправление правосудия и демократические процессы (например, ИИ-решения для поиска судебных решений)

К системам ИИ с высокой степенью риска предъявляются строгие требования, прежде чем они могут быть выведены на рынок:

- адекватные системы оценки рисков и их смягчения

- высокое качество наборов данных, используемых в системе, для минимизации рисков и дискриминационных последствий

- ведение журнала действий для обеспечения прослеживаемости результатов

- подробная документация, содержащая всю необходимую информацию о системе и ее назначении, чтобы власти могли оценить ее соответствие требованиям

- четкая и адекватная информация для разработчика

- надлежащие меры контроля со стороны персонала для минимизации риска

- высокий уровень надежности, безопасности и точности

Все системы удаленной биометрической идентификации считаются высокорискованными и к ним предъявляются строгие требования. Использование удаленной биометрической идентификации в общедоступных местах в правоохранительных целях в принципе запрещено.

Решение для надежного использования крупных моделей искусственного интеллекта

Модели ИИ общего назначения все чаще становятся компонентами систем ИИ. Эти модели могут выполнять и адаптировать бесчисленное множество различных задач.

Хотя модели ИИ общего назначения могут создавать более совершенные и мощные решения ИИ, трудно контролировать все возможности.

Там Закон об ИИ вводит обязательства по обеспечению прозрачности для всех моделей ИИ общего назначения, чтобы обеспечить лучшее понимание этих моделей, а также дополнительные обязательства по управлению рисками для очень эффективных моделей. Эти дополнительные обязательства включают самооценку и снижение системных рисков, отчетность о серьезных инцидентах, проведение тестов и оценки моделей, а также требования к кибербезопасности. /// nCa, 13 августа 2024 г.